华为POL解决方案助力视频监控迈入云化时代

随着发改高技[2015]996号文件《关于加强公共安全视频监控建设联网应用工作的若干意见》提出“立体化社会治安防控体系建设发展”的要求,建设“全域覆盖、全网共享、全时可用、全程可控”的视频联网体系成为公安视频监控发展的新方向。

视频监控作为社会管理的基石,随着社会安防管理需求的不断提升,特别是智能化时代视频数据与警务大数据的碰撞、比对,对视频数据需求量激增,视频监控数量成指数级增加,视频监控接入网络则面临新的需求和挑战。传统视频监控安装场景复杂,需要大量的人力进行调测;网络终端基本安装在室外,长期处于日晒、雨淋、雷击、高温的环境中,设备易损坏;同时室外缺乏监管,非法接入、视频窃取、专网入侵、视频泄露等威胁无处不在;海量的终端接入,全网维护工作量大,同时摄像头更加高清化,带来的网络带宽需求也越来越大。难安装、易损坏、不安全、难维护等问题,成为阻碍视频监控全面云化的主要瓶颈。

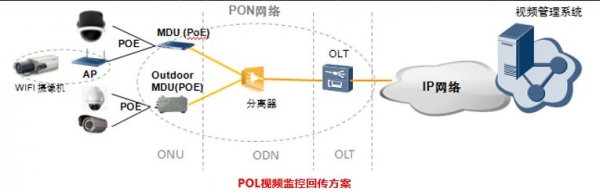

为满足以数据为中心、构建开放共享、高效智能的视频云、实现“一网、一云、一池、一平台”的架构需求,华为在视频监控前端接入网络推出了易安装、高可靠、高安全、易维护、大带宽的POL视频监控接入解决方案,有效突破视频监控网络瓶颈,推动视频监控高清化、智能化发展。

1易安装:

针对各种复杂场景使用需求,华为提供了不同的产品形态来进行满足。针对无法安装网络箱的场景,华为一体机ONU(MA5694S),可直接放置室外起到防尘防水功能;华为还提供了体贴入微的系列化Unisite室外柜,AC/DC电源接入,线束一站式交付和无线接口的ONU设备,保证视频监控即使在没有有线资源,挖沟布线困难的情况下,视频流能正常传送。同时支持光路开通自动化闭环管理,缩短90%开通时间,全网设备支持即插即用,业务自动开通功能,免去人工调测工作。

1高可靠:

为了降低前端接入设备的损坏率,华为根据室外安装场景进行细分,针对一般场景,华为工业级ONU(MA5671铁盒)可以满足-40 ℃ ~55℃宽温需求,抗6KV雷击,同时提供POE供电;而针对极端天气,华为增强型ONU(MA5621)可以满足-40 ℃ ~85℃的超宽温及防雷设计。

1高安全:

华为POL解决方案采用无源光网络传输,做到端到端冗余保护,线路侧采用Type B/Type C双归属保护,保证网络可靠性;前端采取802.1x认证和MAC地址绑定技术,防止前端摄像头非法更换,保障视频流可靠安全。

1易维护:

全网集中式控制,实现统一网管端到端运维管理,告警实时监测,承载网端到端检测,快速故障定责。多重故障诊断手段,维护更加智能:L1层采用eOTDR诊断主干光纤及分支光纤问题,高精度定责;L2层采用Y.1731进行接入段的连通性及性能故障定责,包含丢包、时延、抖动侦测;L3层采用IF-FPM进行连通性及性能故障定责。

1大带宽:

华为POL采用GPON技术,OLT设备单PON口上行带宽1.25G,下行2.5G,单台OLT设备可支撑8000多路前端摄像头的接入;华为PON网络采用QOS技术保障多业务质量,采用CBR(上行支持不同类型T-CONT)技术保障视频监控带宽,提高视频监控业务视频流质量。华为PON网络还支持10G PON/40GPON/100G PON平滑演进,满足海量带宽需求。

目前,华为POL视频监控接入解决方案已经在全球40多个国家得到广泛应用,如上海公安、贵州六盘水平安城市、成都双流机场等超大规模局点项目,产品安装、开通、维护便捷,工作稳定,得到各方一致认可。在公安视频监智能化发展的今天,华为POL视频监控接入解决方案将全面助力视频监控迈入云化时代。

好文章,需要你的鼓励

苹果注重隐私的年龄验证方案可解决两大难题

美国多州和部分国家要求特定应用进行年龄验证,澳大利亚已禁止16岁以下用户使用社交媒体。新提案《应用商店问责法案》建议由苹果和谷歌负责统一验证用户年龄,而非各开发者单独验证。这将提升用户体验,用户只需向苹果或谷歌验证一次身份。凭借苹果在隐私保护方面的优势,该方案可扩展至Safari浏览器,为需要年龄验证的网站提供确认信息,而无需透露用户个人数据。

Meta AI团队首次破解多模态奖励模型评估难题,让AI既能看懂图片又能准确判断好坏

Meta AI首次发布多模态奖励评估基准MMRB2,专门评价AI同时处理文字和图像的能力。该基准包含四大任务类型共4000个专家标注样本,测试23个先进模型。结果显示最佳模型Gemini 3 Pro达75-80%准确率,仍低于人类90%水平。研究揭示AI评价存在视觉偏见等问题,为多模态AI发展提供重要参考标准。

Cursor通过收购Graphite继续扩张之路

AI编程助手Cursor背后的公司Anysphere宣布收购AI代码审查工具初创公司Graphite。据报道收购价远超Graphite今年早些时候B轮融资时2.9亿美元的估值。此次收购具有战略意义,将AI代码生成与AI代码审查工具相结合,可大幅提升从编写到交付的整体效率。Anysphere估值已达290亿美元,近期频繁收购,上月收购技术招聘公司,今年7月还收购AI客户关系管理初创公司Koala的团队。

快手推出Kling-Omni:一个AI模型搞定所有视频制作需求

快手推出的Kling-Omni是首个真正统一的AI视频制作系统,能够理解文字、图像、视频等多种输入方式,不仅可以生成视频,还能进行复杂编辑和推理。该系统通过三个核心模块的协作,实现了从创意理解到最终输出的全流程自动化,让普通用户也能制作专业水准的视频内容,代表了AI视频技术的重要突破。

联想问天 WR5220 G5服务器

联想问天 WA7880a G3服务器

苹果注重隐私的年龄验证方案可解决两大难题

Cursor通过收购Graphite继续扩张之路

ChatGPT新增个性化设置功能,用户可自定义聊天体验

Kuxiu S3固态电池充电宝替代多款充电器的全能解决方案

Waymo自动驾驶出租车遭遇交通灯故障停摆事件分析

智启未来,共筑开发者生态 AMD携手DataWhale、魔搭社区,共建ROCm开发者生态

千问C端事业群成立后首推平价AI眼镜:低至1999元,搭载千问AI助手

Aqara Hub M200为HomeKit带来Matter支持和新自动化选项

LG智能电视强制安装Copilot快捷方式引发用户不满

Palo Alto Networks与谷歌云签署数十亿美元AI合作协议

智简融媒 创新视听|华为助力传媒行业发展新质生产力

华为 Mate X6 折叠屏手机外观公布开启预定,26 日同期发布

万余款数智产品、上千场全国行动 华为联手上万家伙伴启动第三届828 B2B企业节

华为如何抓住全闪化百亿市场新机遇?

闪存普惠,一步到位 华为正式发布极简全闪数据中心暨伙伴先锋行动

华为发布园区网络“光进铜退”先锋行动 ——将投入5000万元营销资源支持新老伙伴共赢园区数智新未来

华为老将余承东,字典里没有躺平

新商机|新标配|新支持,园区网络光进铜退先锋行动发布会

华为发布星河AI网络解决方案,携手全球伙伴共同倡议加快Net5.5G产业演进发展

华为陈帮华:打造F5G-A高品质运力网,形成“全国一台计算机”