庆祝香港回归20周年 首届港澳地区大专联校网络安全竞赛圆满成功

6月10日,为庆祝香港回归20周年,香港特别行政区政府创新科技署应用科技研究院(应科院)主办,i春秋学院承办,腾讯安全平台部、XCTF联赛协办的首届港澳地区大专联校网络安全竞赛圆满结束。在4月份的初赛中,来自香港大学、香港科大、浸会大学、澳门科技大学的96支战队317名选手报名了比赛,最终 8支队伍从初赛中突围,最终进入决赛。本次竞赛是港澳地区首次举办的信息安全竞赛,参与院校之多、竞赛水准之高、影响范围之大,超出了预期。本次比赛得到了包括香港信息安全学院、HKT®(香港电讯)、FireEye、CyberWorld、政府电脑保安事故协调中心等企业和机构的赞助支持。

决赛采用CTF解题模式,各大战队齐聚香港应科院总部,进行现场比拼,团队通过提交正确的Flag得分。赛前,香港特区政府咨询科技总监杨德斌、应科院副总裁王世松、i春秋副总裁姚磊分别出席致辞,对参赛选手给予重视和竞赛鼓舞。本次的赛题难度和涵盖范围都接轨国际赛事,对参赛选手的知识储备、应变能力和综合协作能力提出了更高要求。

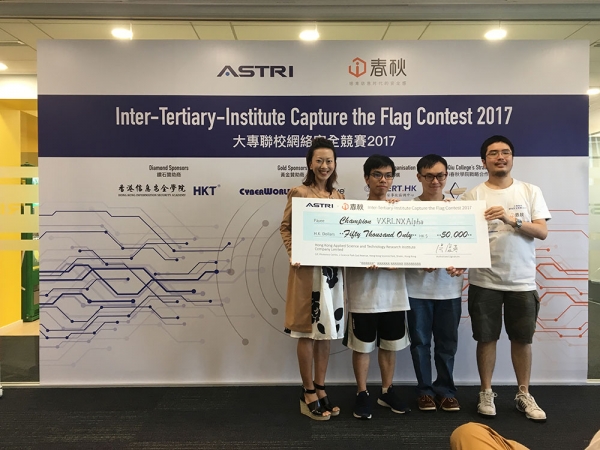

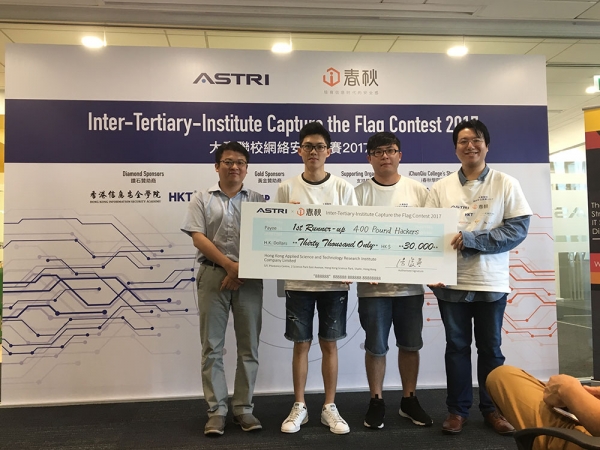

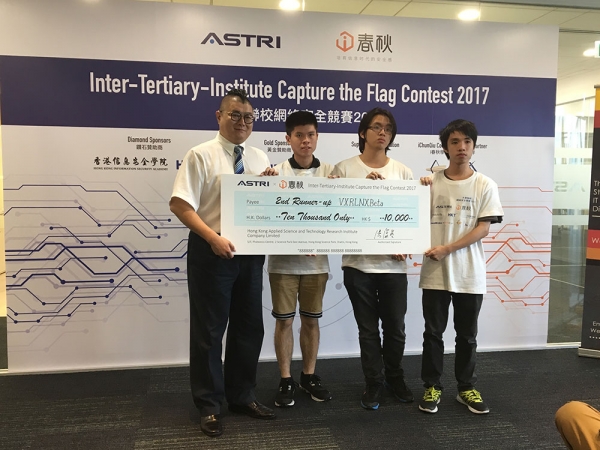

经过7个小时的激烈角逐,最终香港科技大学VXRLNXAlpha战队以总分1000分的成绩,获得第一名,并赢得50000港币大奖。来自的香港理工大学的400 pound Hackers战队和香港科技大学的VXRLNXBeta战队分获二、三名,并赢得30000元、10000元港币奖金。比赛定格的画面激动人心,似乎还能感受到赛场上的激烈夺旗的氛围。

应科院HR总监朱丽仪为一等奖获奖队伍颁奖

i春秋副总裁姚磊为二等奖获奖队伍颁奖

香港信息安全学院 CEO 庞博文为三等奖获奖队伍颁奖

i春秋姚磊表示:“这次比赛选手展现了高超的水平,i春秋很高兴能够为港澳学生带来专业水准的网络安全竞赛,同时也在这样的交流中,感受到港澳学子的活力及能量。希望通过i春秋的知识学习库和竞赛举办实力,未来进行更多的人才培养、赛事运营的合作,以及促进两岸三地的人才和教育交流,为培育信息时代的安全感而努力。“

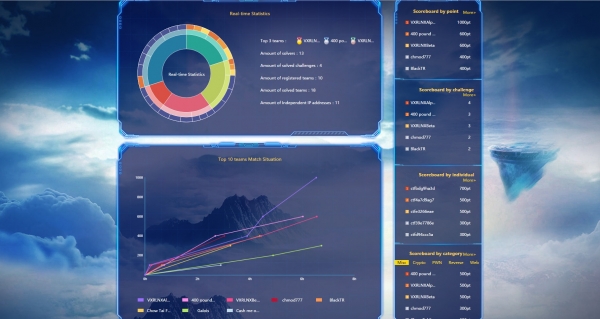

比赛结果页

当今社会处于无处不网、无事不网、无时不网的时代,互联网已经渗透到生活的各领域。 6月1日,《网络安全法》正式实施,明确了公民的网络安全义务,对企业设定了更加严格的要求,企业必须提高运行安全能力,采取必要的措施,提高网络安全水平。人才是企业网络安全的核心,竞赛是快速提高网络安全人才水平的途径。i春秋是国内最大的信息安全在线教育平台,独创了听课-实验-交流-竞赛的人才培养模式,能为企业精准、高效的输送人才。过去的2016年,i春秋技术支持的网络安全竞赛占全国竞赛的半壁江山,覆盖从线下到线上、从职业选手至中小学生、从国内大赛到国际联赛、成绩丰硕,得到了客户、合作伙伴的认可。

比赛定格瞬间

在香港回归20周年之际,香港已经在经济发展和科技创新上取得了繁荣稳定的进步。本次首届港澳地区大专联校网络安全竞赛多方联动,对检验高校学子的学习成果,培养大学生网络安全实战能力起到十分重要的作用,为国家网络安全人才储备打下坚实基础。

i春秋如今在国内的港澳台两岸三地和海外的澳洲成功开拓网络安全合作疆域,正在为国内乃至国际输送培养更多人才而努力,以后也将继续积极投身于国家网络信息安全建设,在网络安全保障工作中贡献一方之力。

好文章,需要你的鼓励

奥运级别的努力:首席信息官为2026年AI颠覆做准备

AI颠覆预计将在2026年持续,推动企业适应不断演进的技术并扩大规模。国际奥委会、Moderna和Sportradar的领导者在纽约路透社峰会上分享了他们的AI策略。讨论焦点包括自建AI与购买第三方资源的选择,AI在内部流程优化和外部产品开发中的应用,以及小型模型在日常应用中的潜力。专家建议,企业应将AI建设融入企业文化,以创新而非成本节约为驱动力。

字节跳动发布GAR:让AI能像人类一样精准理解图像任何区域的突破性技术

字节跳动等机构联合发布GAR技术,让AI能同时理解图像的全局和局部信息,实现对多个区域间复杂关系的准确分析。该技术通过RoI对齐特征重放方法,在保持全局视野的同时提取精确细节,在多项测试中表现出色,甚至在某些指标上超越了体积更大的模型,为AI视觉理解能力带来重要突破。

Spotify推出AI播放列表功能让用户掌控推荐算法

Spotify在新西兰测试推出AI提示播放列表功能,用户可通过文字描述需求让AI根据指令和听歌历史生成个性化播放列表。该功能允许用户设置定期刷新,相当于创建可控制算法的每周发现播放列表。这是Spotify赋予用户更多控制权努力的一部分,此前其AI DJ功能也增加了语音提示选项,反映了各平台让用户更好控制算法推荐的趋势。

Inclusion AI推出万亿参数思维模型Ring-1T:首个开源的超大规模推理引擎如何重塑AI思考边界

Inclusion AI团队推出首个开源万亿参数思维模型Ring-1T,通过IcePop、C3PO++和ASystem三项核心技术突破,解决了超大规模强化学习训练的稳定性和效率难题。该模型在AIME-2025获得93.4分,IMO-2025达到银牌水平,CodeForces获得2088分,展现出卓越的数学推理和编程能力,为AI推理能力发展树立了新的里程碑。

为AI+而生,海辰储能发布全球首款锂钠协同AIDC全时长储能解决方案

长时储能开启智慧未来:海辰储能生态日全球首发三大新品

Arm 借助融合型 AI 数据中心,重塑计算格局

奥运级别的努力:首席信息官为2026年AI颠覆做准备

Spotify推出AI播放列表功能让用户掌控推荐算法

Adobe押注生成式AI获得回报,年度营收创历史新高

OpenAI与迪士尼达成十亿美元合作协议,米老鼠和漫威角色进入Sora

甲骨文150亿美元数据中心投资导致股价下跌

Spoor鸟类监测AI软件需求飞速增长

制药行业AI数据质量危机:垃圾进垃圾出的隐患

Harness获得2.4亿美元融资,估值达55亿美元,专注自动化AI编码后的开发流程

英伟达CEO黄仁勋独家专访:万亿美元押注AI工厂将成为新时代计算机