受更新迭代影响 梭子鱼Q4增长幅度见缓

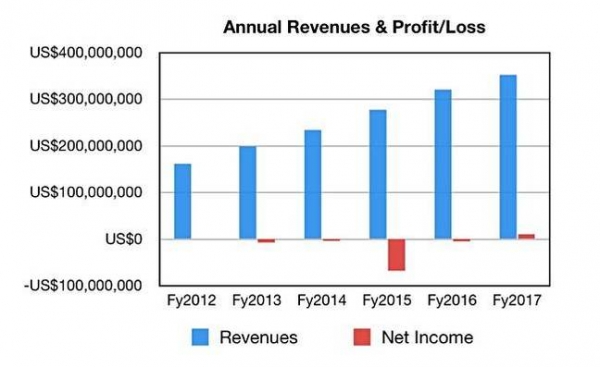

ZD至顶网安全频道 04月21日 综合消息:在2017财年第四季度,梭子鱼收入8930万美元,同比增长6.7%,但环比仅增长0.6%。利润为320万美元,与去年同期数字相同,环比增长77.8%。

2017财年的全年收入为3.526亿美元,相比2016年高出10.12%,利润为1020万美元,远远好于去年同期的亏损440万美元。

所以我们看到了好的、但还不够令人兴奋的结果,但不管怎样业务仍在增长中。梭子鱼公司总裁兼首席执行官BJ Jenkins在他的声明中提到“表现稳定的第四季度”。“我们的表现实现了创纪录的收益以及公司历史上最高的5890万美元现金流。”

在第四季度业绩中,订阅是占主导的:

- 订阅收入增长至6940万美元,相比去年同期的6210万美元增加了12%,在总收入中占比78%

- 应用收入为1990万美元,相比之下去年同期为2170万美元

- 全年应用收入为8270万美元,相比之下去年同期为8930万美元

- 总交易额为1.032亿美元,相比之下去年同期为9580万美元

- 核心产品交易额增长21%至6380万美元,相比之下去年同期为5260万美元

- 活跃订阅用户的数量同比增长了15%,截止2017年2月28日达到321000,在该季度新增了12000的订阅用户

- 基于美元的更新率为89%(按照恒定货币计算为90%)

William Blair分析师Jason Ader评论称:“更新率再次减少,为89%,主要是由于受到了来自合约期缩短、过渡到云、货币逆势以及传统业务下滑的影响。基于美元的年更新率为97%,保持健康状态,基于单位量的更新率保持不变,客户增幅为15%(321000个订阅用户),情况同样良好。”

展望下个季度,交易额预计增加5.9%,在1.03到1.05亿美元之间,收入在9000万到9200万美元之间,这意味着同比增幅为5%,中间点为9100万美元。

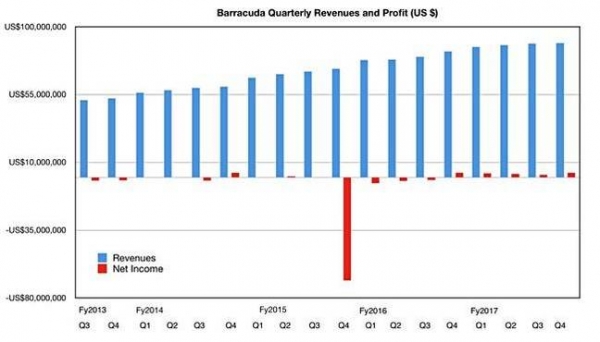

梭子鱼公司的季度收入和利润情况

上面这张季度收入和净收益图表显示了季度收入增幅最近保持持平,从全年看的状况显示稳定的同比增长:

我们看到这家公司对客户从内部部署的设备转向公有云和订阅模式做出了反应,利润表现却不是特别抢眼。梭子鱼的订阅用户群环比增加了12000个,同比增加了近43000个,但是利润仍然保持持平;320万美元,反映出设备销售的亏损状况。

Ader写道:“梭子鱼再一次在交易额、收入和EPS方面超出了华尔街的预期,这主要是收到了稳健执行的带动……我们很高兴看到该公司在转型成为一家公有/私有云安全及基础设施提供商方面取得的进展,该公司的核心业务交易额增长了21%,公有/私有云的客户数突破了1000家。”

财报电话会议

Jenkins在财报电话会议上提到了公司专注于云和安全。“梭子鱼的愿景是成为中端市场的领先安全平台。为了实现这个目标,我们将把投资、产品组合和发展路线与市场保持一致,以满足我们客户更多采用云、SaaS和管理服务、付费即用的IT部署模式以及批量结算选项的需求。”

这里的“安全”涵盖电子邮件安全和管理、网络和应用安全、数据加密。“电子邮件安全和管理使我们平台的基石。电子邮件仍然是主要的威胁因素,并且是企业迁移到云的首批应用之一……我们现在有超过1000家客户在公有云中采用我们的安全解决方案。”

Jenkins表示,公司有一些三年、五年的订阅交易现在已经更新为年度交易,甚至还有一些更短期的交易。很多交易也出现了一些变化,例如Intronis MSP产品,是按月付费的。

梭子鱼公司首席财务官Dustin Driggs称公司是以美国为中心的业务。“从区域来看,我们第四季度的收入中有76%来自美洲,18%来自EMEA,6%来自亚太。”

他补充说:“我们今年的自由现金流是5890万美元,比去年增加了42%。”

Ader写道:“梭子鱼正在从内部部署设备转向为基于云的解决方案方面取得显著的进展,同时也在加速核心业务的增长,公有云还处于发展初期,梭子鱼在企业级市场的领先地位尚未得到充分证明。”

好文章,需要你的鼓励

Allen AI团队推出SAGE:首个能像人类一样“想看多长就看多长“的智能视频分析系统

Allen AI研究所联合多家顶尖机构推出SAGE智能视频分析系统,首次实现类人化的"任意时长推理"能力。该系统能根据问题复杂程度灵活调整分析策略,配备六种智能工具进行协同分析,在处理10分钟以上视频时准确率提升8.2%。研究团队创建了包含1744个真实娱乐视频问题的SAGE-Bench评估平台,并采用创新的AI生成训练数据方法,为视频AI技术的实际应用开辟了新路径。

联想推出DE6600系列:更智能的存储解决方案

联想推出新一代NVMe存储解决方案DE6600系列,包含全闪存DE6600F和混合存储DE6600H两款型号。该系列产品延迟低于100微秒,支持多种连接协议,2U机架可容纳24块NVMe驱动器。容量可从367TB扩展至1.798PiB全闪存或7.741PiB混合配置,适用于AI、高性能计算、实时分析等场景,并配备双活控制器和XClarity统一管理平台。

AI视觉模型真的能看懂长篇文档吗?中科院团队首次揭开视觉文本压缩的真相

中科院团队首次系统评估了AI视觉模型在文本压缩环境下的理解能力,发现虽然AI能准确识别压缩图像中的文字,但在理解深层含义、建立关联推理方面表现不佳。研究通过VTCBench测试系统揭示了AI存在"位置偏差"等问题,为视觉文本压缩技术的改进指明方向。

数智时代,openGauss Summit 2025即将发布哪些技术创新破局

“算力+储能”深度融合:超智算发布分布式算力超级节点储能解决方案

联想推出DE6600系列:更智能的存储解决方案

创业公司如何在严格监管行业中实现生死攸关的创新

OpenAI发布GPT-5.2-Codex模型,软件工程自动化能力大幅提升

Waterfox浏览器宣布拒绝AI功能,瞄准Firefox忠实用户

TikTok美国业务出售交易将于下月完成

破局AI数据中心安全瓶颈:Fortinet联合NVIDIA引领隔离式加速新航向

智算中心进化论,科华数据如何做到“更懂”

更高负载、更快建设:2026年数据中心六大趋势

Snowflake数据库更新引发全球大规模服务中断

AI编程初创公司Lovable融资3.3亿美元,英伟达等科技巨头支持